Купить Одновременный сбор данных по нескольким параметрам

В современном мире, где информация – это ключевой ресурс, умение собирать и анализировать данные становится всё более востребованным. Особенно актуально это становится, когда речь идет о сборе данных по нескольким параметрам одновременно. Это позволяет получить гораздо более полную и объективную картину происходящего, чем при анализе отдельных показателей. Рассмотрим, какие инструменты и методы существуют для эффективного Купить Одновременный сбор данных по нескольким параметрам и какие проблемы могут возникнуть в процессе.

Почему важен одновременный сбор данных?

Представьте себе ситуацию: вы пытаетесь оценить эффективность рекламной кампании. Если вы собираете данные только по количеству кликов, вы получите лишь часть информации. Важно учитывать и другие параметры, такие как стоимость клика, конверсия, демографические данные пользователей, географическое расположение и т.д. Без комплексного подхода вы не сможете сделать обоснованные выводы и оптимизировать кампанию. То же самое касается анализа данных о продажах, клиентской активности, эффективности работы оборудования – чем больше параметров вы учитываете, тем точнее и ценнее становится полученная информация. Многие компании сейчас сталкиваются с необходимостью собирать и интегрировать данные из различных источников: CRM-систем, маркетинговых платформ, аналитических сервисов, датчиков IoT. Автоматизация этого процесса с использованием специализированных решений – это не просто удобство, это необходимость для конкурентоспособности.

Пример из практики: анализ поведения пользователей на сайте

Предположим, вы хотите понять, как пользователи взаимодействуют с вашим интернет-магазином. Если собирать данные только о количестве посещений страниц, это не даст вам полной картины. Необходимо учитывать: время, проведенное на каждой странице, какие кнопки нажимают, какие товары добавляют в корзину, откуда приходят пользователи (по поисковым запросам, из социальных сетей, с email-рассылок), какие устройства используют (компьютер, смартфон, планшет). Анализ этих данных в совокупности позволит выявить узкие места в пользовательском пути, оптимизировать структуру сайта, улучшить пользовательский опыт и увеличить конверсию. Для такой задачи часто используют комплексные аналитические платформы, позволяющие интегрировать данные из различных источников и проводить глубокий анализ.

Какие инструменты можно использовать для одновременного сбора данных?

Выбор инструмента зависит от ваших конкретных потребностей, бюджета и технических возможностей. Существует широкий спектр решений, от простых скриптов до сложных программных платформ. Вот несколько популярных вариантов:

1. Специализированные аналитические платформы

Такие платформы, как Amplitude, Mixpanel, Heap, предназначены для анализа поведения пользователей на веб-сайтах и в мобильных приложениях. Они позволяют собирать данные о взаимодействиях пользователей с различными элементами интерфейса, отслеживать пользовательские пути, сегментировать аудиторию и создавать отчеты. Особенность этих платформ в том, что они предоставляют готовые решения для анализа наиболее распространенных сценариев использования, что значительно упрощает процесс. Например, Amplitude позволяет отслеживать различные события (клик, загрузка, добавление в корзину) и создавать сложные воронки конверсии. ООО Чунцин Кайжун Чуаньи Прибор предлагает решения для интеграции данных из различных источников и построения комплексных аналитических дашбордов.

2. ETL-инструменты (Extract, Transform, Load)

ETL-инструменты предназначены для извлечения данных из различных источников, их преобразования в единый формат и загрузки в хранилище данных. Примеры таких инструментов: Apache Kafka, Apache NiFi, Talend Open Studio. Они особенно полезны, когда данные поступают из разных систем и имеют разный формат. ETL-инструменты позволяют автоматизировать процесс интеграции данных, обеспечивать их качество и актуальность. Они идеально подходят для построения data lakes и data warehouses.

3. Собственные скрипты и приложения

Если вам нужны специфические данные, которые не предоставляются готовыми решениями, вы можете написать свои собственные скрипты и приложения для сбора данных. Например, вы можете написать скрипт на Python, который будет собирать данные с веб-сайта, API или базы данных. Этот подход требует определенных навыков программирования, но позволяет получить максимальный контроль над процессом сбора данных. Многие компании используют комбинацию готовых инструментов и собственных скриптов для решения своих задач.

Какие сложности могут возникнуть при сборе данных по нескольким параметрам?

Несмотря на наличие множества инструментов и решений, процесс сбора данных по нескольким параметрам может быть достаточно сложным. Вот некоторые из наиболее распространенных проблем:

1. Совместимость данных

Данные могут поступать из разных источников в разном формате. Необходимо обеспечить их совместимость, чтобы можно было их объединить и проанализировать. Это может потребовать преобразования данных, очистки от ошибок и дубликатов.

2. Объем данных

При сборе данных по нескольким параметрам объем данных может быть очень большим. Это может создавать проблемы с хранением, обработкой и анализом данных. Необходимо использовать эффективные методы хранения и обработки данных, такие как data lakes, data warehouses и облачные вычисления.

3. Качество данных

Данные могут содержать ошибки, пропуски и неточности. Необходимо обеспечить качество данных, чтобы можно было на них полагаться при принятии решений. Это требует использования методов очистки данных и валидации.

4. Правовые аспекты

Сбор и обработка данных могут быть связаны с правовыми ограничениями, такими как GDPR. Необходимо соблюдать эти ограничения, чтобы избежать штрафов и юридических проблем.

Перспективы развития

Технологии сбора и анализа данных постоянно развиваются. В будущем можно ожидать появления новых инструментов и решений, которые будут еще более эффективными и удобными в использовании. Особое внимание будет уделяться искусственному интеллекту и машинному обучению, которые позволят автоматизировать процесс сбора и анализа данных, выявлять скрытые закономерности и делать более точные прогнозы. Более того, будут развиваться технологии IoT (Интернет вещей), обеспечивающие постоянный поток данных от различных устройств и датчиков.

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

Промышленные ИБП серии ETT9000 (3-фазный вход / 3-фазный выход)

Промышленные ИБП серии ETT9000 (3-фазный вход / 3-фазный выход) -

Сенсорный силовой шкаф постоянного тока UPD-Ⅲ тип

Сенсорный силовой шкаф постоянного тока UPD-Ⅲ тип -

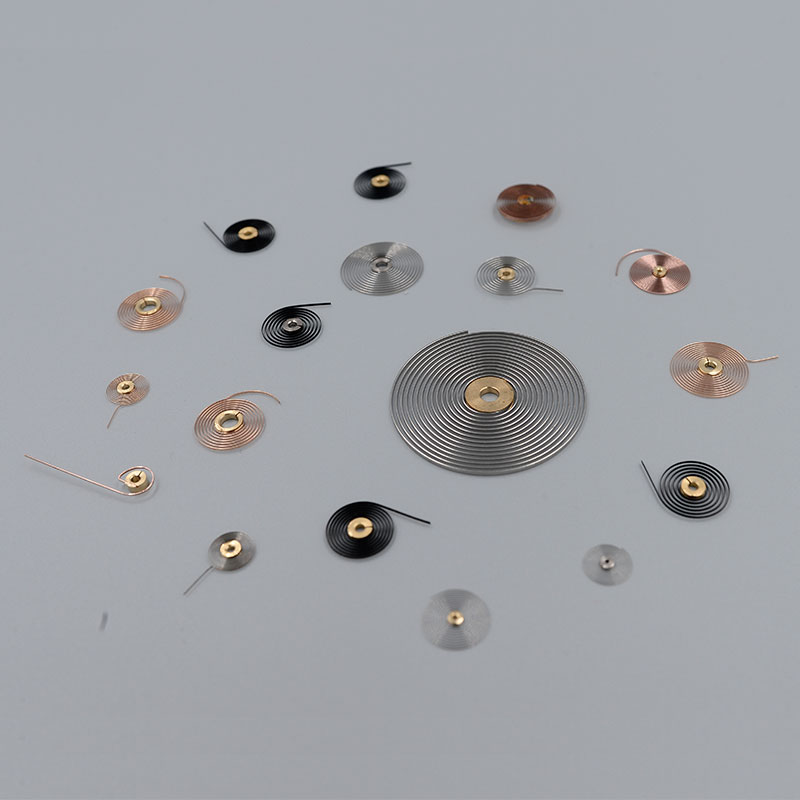

Волосковая пружина механического инструмента

Волосковая пружина механического инструмента -

Гибридный шкаф электропитания EPS серии RK-D

Гибридный шкаф электропитания EPS серии RK-D -

Биметаллический элемент температуры и влажности

Биметаллический элемент температуры и влажности -

Интегрированная система источник питания для железнодорожного транспорта

Интегрированная система источник питания для железнодорожного транспорта -

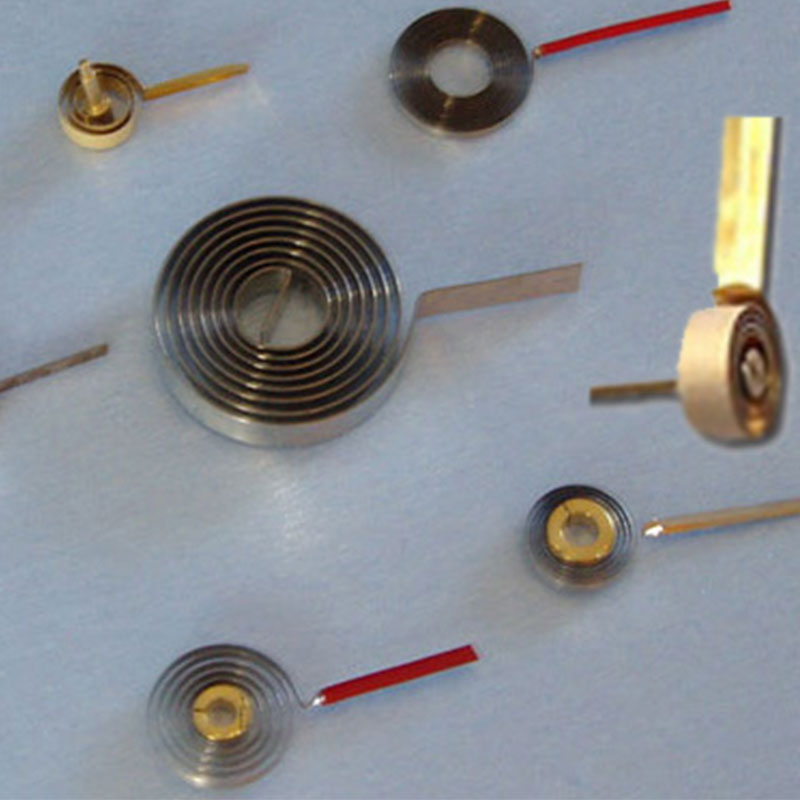

Волосковая пружина для прибора

Волосковая пружина для прибора -

Плоская многооборотная пружинная трубка

Плоская многооборотная пружинная трубка -

ИБП энергосистема хранения энергии серии SPS

ИБП энергосистема хранения энергии серии SPS -

Обработка тонких и длинных валов

Обработка тонких и длинных валов -

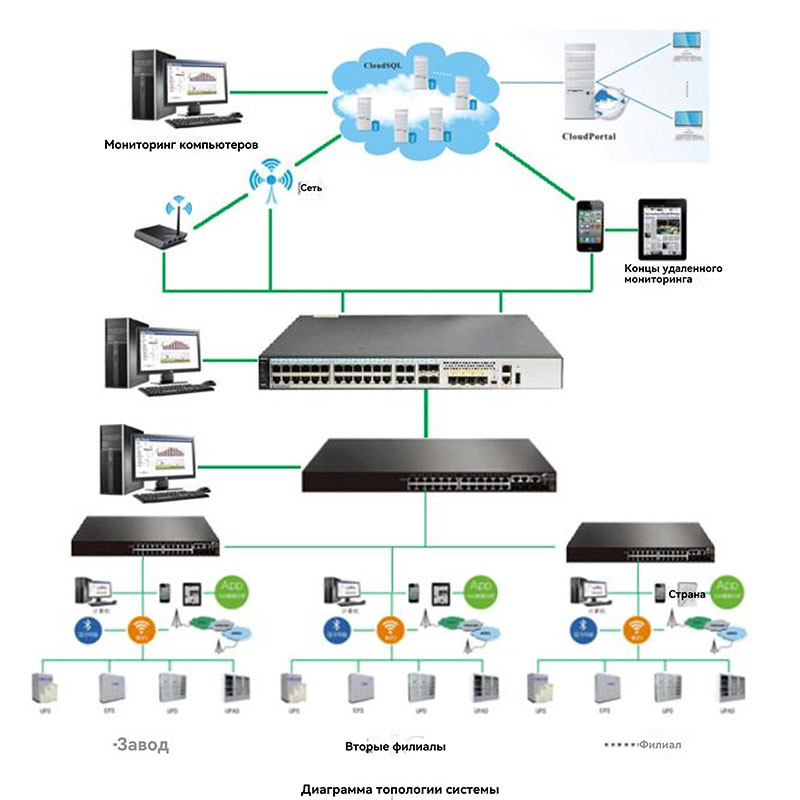

Система управления облачными сервисами комплексного мониторинга источник питания

Система управления облачными сервисами комплексного мониторинга источник питания -

Стабилизатор переменного напряжения серии JWK

Стабилизатор переменного напряжения серии JWK

Связанный поиск

Связанный поиск- Шкаф питания с защитой от перенапряжения

- Производство источников питания для промышленного оборудования в Китае

- Покупка производителя систем онлайн-мониторинга аккумуляторных батарей

- Производители зеленых энергосберегающих силовых шкафов

- Промышленные блоки питания постоянного тока в Китае

- Купить зарядную станцию для оптических накопителей

- Купить Интегрированная система электроснабжения

- Поставщики систем управления выравниванием заряда одной ячейки

- Завод покупающий блоки питания с удаленным мониторингом и устранением неисправностей

- Производитель литиевых аккумуляторов